KI-Systeme denken anders

Mehr als ein schlauer Mensch?

- von Cathrin Becker

- 21.03.2022

Künstliche Intelligenz ist uns oft noch fremd. Was wir tun können, um sie besser zu verstehen.

Wäre Künstliche Intelligenz ein Alien, wie wäre es? Freundlich wie E.T., hilfsbereit wie kleine grüne Marsmännchen oder ein zähnefletschendes Monster, das uns ängstigt? „Wahrscheinlich für jeden anders, aber KI ist eine so andere Art von Verarbeitung, als wäre sie nicht von dieser Welt“, meint Professorin Dr. Nicole Krämer. Das Bild von Außerirdischen, die wir uns mit der Entwicklung Künstlicher Intelligenz auf die Erde geholt haben, findet sie sehr treffend. Es stammt von dem bekannten Physiker und Wissenschaftsjournalist Harald Lesch.“

Warum ist es so schwierig für uns, KI einzuordnen? Wie funktioniert die Mensch-Technik-Interaktion mit neuen, intelligenten Systemen? Das sind Fragen, mit denen sich Krämer, Leiterin des Fachgebiets Sozialpsychologie, beschäftigt. „Wir sind darauf ausgerichtet, menschliche Intelligenz zu verstehen, aber Maschinelles Lernen und KI funktionieren anders als unser Denken, deshalb kommen sie uns so fremd vor."

Was lernt die Maschine?

Ob menschliche oder künstliche Intelligenz: Die Disziplinen sind sich nicht einig, wie man das eine und das andere definiert (siehe auch hier). Klar ist, dass man schon in den 1960er Jahren versuchte, unsere Intelligenz in einem formalisierten Modell zu beschreiben und dies in Computerprogrammen nachzubilden. Das war auch der ursprüngliche Gedanke: KI sollte uns helfen, ergänzen und verbessern.

Einfach nur der schlauere Mensch ist KI aber nicht. Wenn heute die Systeme rasend schnell große Datenmengen analysieren und daraus Vorschläge und Entscheidungen ableiten oder menschliche Gegner im Schach oder beim Strategiespiel Go schlagen, sind sie in eng begrenzten Domänen schon jenseits des menschlichen Denkens und Verarbeitens angekommen. Mit den massenhaft aus dem Netz, insbesondere den Sozialen Netzwerken, gewonnenen Informationen plus gesteigerten Rechenkapazitäten wurde eine datenbasierte Form der Künstlichen Intelligenz möglich, eben das Maschinelle Lernen. Wir bestimmen dabei nur noch die Rahmenbedingungen. „Was die Maschine tatsächlich lernt oder welche Zusammenhänge sie findet, bleibt für Außenstehende unklar. Sogar die Programmierer:innen wissen es in vielen Fällen nicht, da das System aufgrund von ganz eigenen und meist nicht mit dem menschlichen Vorgehen zu vergleichenden Prozessen lernt und beispielsweise Muster findet, die ein Mensch sich nicht erschließen würde“, gibt Krämer zu bedenken.

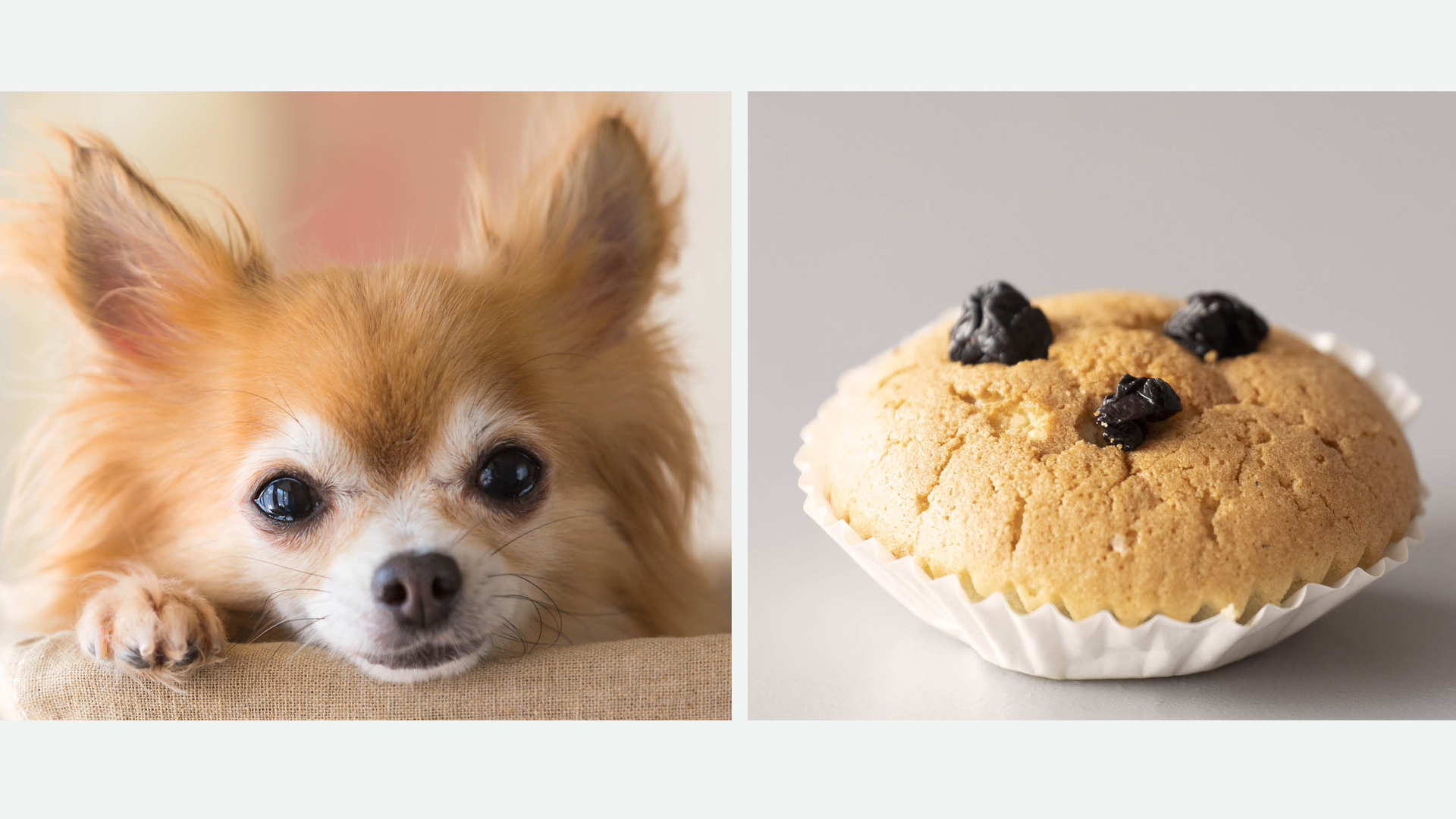

Doch das Maschinelle Lernen hat auch Grenzen – und der Mensch was zu lachen. So amüsierte man sich im Internet bei der so genannten Dog-or-Muffin-Challenge darüber, dass die Algorithmen nicht in der Lage waren, den treuen Blick eines kleinen braunen Hundes von Schokostücken in einem Muffin zu unterscheiden. Dass der Mensch hier überlegen ist, wird heute gern für Captcha, also Sicherheitsabfragen auf Webseiten, genutzt: Wenn man zum Beispiel aufgefordert wird, auf einer Reihe von Fotos all diejenigen anzuklicken, die eine Ampel enthalten, oder man eine verzerrt dargestellte, willkürliche Zahlen-Buchstaben-Kombination eingeben soll.

Blackbox KI öffnen

Was wir kennen, können wir nachvollziehen; wie andere Menschen denken, fühlen und planen, verstehen wir deshalb – nicht aber, wie das bei Maschinen geht. Professorin Nicole Krämer geht von verschiedenen Möglichkeiten aus, wie Menschen zu Schlussfolgerungen über das Funktionieren von Maschinen kommen. Eine ist, dass wir Annahmen über unser eigenes Verhalten und Funktionieren auf die Maschine übertragen – damit müssen wir zwangsläufig in Kauf nehmen, auch falsche Annahmen zu treffen.

Dieser Schritt wird dadurch unterstützt, dass wir zum Beispiel Roboter menschenähnlich aussehen lassen, ihn trainieren, so dass er uns imitiert oder nach unseren Vorlieben agiert. „Denken Sie an kommunizierende Geräte oder Sprachassistenten wie Alexa. Man kann beobachten, dass viele Leute die Interaktion vermenschlichen, was nicht überraschend ist. Denn es laufen dann unbewusst und automatisch soziale Skripte ab, etwa, dass wir die Maschine höflich behandeln oder uns wie einem Menschen gegenüber in einem positiven Licht darstellen“, stellt die Psychologin in ihren Studien fest. Bekommt eine Maschine dann noch ein sympathisches Gesicht oder niedliche Kulleraugen, weckt das bei den meisten Emotionen.

Ein anderer Ansatz, sich mit KI vertraut zu machen, ist: sich zu informieren. „Tatsächlich scheinen die meisten Nutzer:innen nur eine vage Ahnung davon zu haben, wie intelligente Algorithmen arbeiten“, sagt Krämer und verweist auf entsprechende Studien. Diese zeigen, dass sich ein Teil der Befragten lediglich vorstellen kann, dass das System auf Basis von gesammelten Daten funktioniert. Andere Ideen sind hingegen stark geprägt von Filmen und Medien, bei denen Maschinen vermenschlicht werden und ein Eigenleben führen. „Sie werden auch gern in ihrer Intelligenz überhöht dargestellt, was natürlich so noch nicht stimmt.“

Doch wie können wir uns ein realistisches Bild machen? Eine weitere Lösung könnte die „Explainable Artificial Intelligence“ sein, also eine erklärbare KI. Hier soll das, was die lernenden Algorithmen an Zusammenhängen und Entscheidungsmustern produziert haben, in eine für Menschen verständliche Sprache übersetzt werden. „Nicht nur diejenigen, die programmieren, sondern vor allem die Nutzenden sollen verstehen können, wie das System zu seinen Ergebnissen und Empfehlungen kommt. Das schafft Vertrauen.“

Vertrauen schaffen durch zertifizierte Systeme

Genutzt wird dabei beispielsweise die kontrafaktische Methode, das heißt: Auf Basis der Daten, mit der die Maschine lernt – also gesprochene Sprache, Texte oder Bilder – wird zunächst beobachtet, wie sich das Resultat verändert. Auf diese Weise wird nachvollzogen, wie das System arbeitet. „Wichtig ist allerdings, zusätzlich Vertrauen herzustellen, zum Beispiel durch eine offizielle Prüfung und Zertifizierung von Systemen“, meint Krämer. „Ähnlich wie ein Großteil der Bevölkerung nicht genau verstehen kann, wie eine mRNA-basierte Impfung funktioniert, sich aber dennoch impfen lässt, weil die Menschen den Zulassungsprozessen vertrauen.“

Vertrauen und Offenheit sind also wichtig, um Künstliche Intelligenz verstehen zu lernen – damit sie für uns nicht das furchteinflößende übermenschliche Alien bleibt, aber doch mehr sein kann als das niedliche Runzelgesicht E.T.

Nicole Krämer

Die 49-jährige Professorin für Sozialpsychologie ist seit 2007 an der UDE und forscht seit vielen Jahren zur Mensch-Technik-Interaktion und der computervermittelten Kommunikation.

Zum Weiterlesen: Krämer, N. et al. (2019). KI-basierte Sprachassistenten im Alltag: Forschungsbedarf aus informatischer, psychologischer, ethischer und rechtlicher Sicht. Universitätsbibliothek, UDE.